搜索引擎优化什么才是最重要的

站长搜索网 2020-05-15 00:08 798 浏览 0 评论

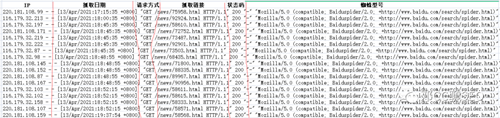

当一个搜索引擎程序抓取网站时,其实我们可以通过相关文件进行引导的。简单的理解搜索引擎蜘蛛会通过链接来了解您网站上的信息。但他们也在浏览网站代码和目录中的特定文件,标签和元素。

robots.txt

搜索引擎蜘蛛会在抓取网站时,第一件事就是先抓取robots.txt文件。对于复杂的网站,robots.txt文件是必不可少的。对于只有少数几页的小型网站,robots.txt文件可能不是必需的。没有它,搜索引擎蜘蛛就会抓取网站上的所有内容。

有两种主要方法可以使用robots.txt文件指导搜素引擎蜘蛛。

首先,可以使用“禁止”指令。这会引导蜘蛛忽略特定的URL文件,文件扩展名甚至整个网站的部分:

User-agent: Googlebot

Disallow: /example/

虽然disallow指令会阻止蜘蛛爬取您网站的特定部分(因此节省抓取预算),但它不一定会阻止该页面被索引并显示在搜索结果中,例如可以在此处看到:

另一种方法是使用 noindex 指令。Noindex某个页面或文件不会阻止它被抓取,但是,它会阻止它被索引(或从索引中删除它)。此robots.txt指令由Google非正式支持,并且完全不受Baidu/Bing支持:

User-agent:Googlebot

Noindex:/ example /

User-agent:*

Disallow:/ example /

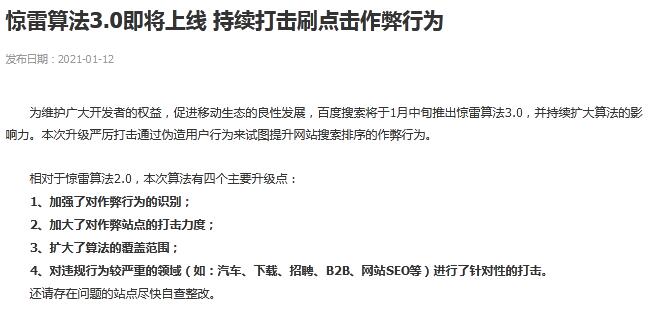

显然,由于这些网页仍在被抓取,它们仍会使用您的抓取预算。这是一个常常被忽略的问题:disallow指令实际上会撤消搜索引擎蜘蛛noindex标记的工作。这是因为disallow阻止蜘蛛访问网页的内容,从而阻止了看到和遵守meta标签。另一个使用robots.txt协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。当然,并不是所有蜘蛛都行为良好,有的甚至会忽略你的指令(尤其是寻找漏洞的恶意机器人)。

XML站点地图

XML站点地图帮助蜘蛛了解站点的基础结构。在这请注意,蜘蛛使用站点地图作为线索,而不是权威指南,了解如何为网站建立索引。机器人还会考虑其他因素(例如您的内部链接结构)来弄清楚您的网站是关于什么的。使用可扩展标记语言(XML)站点地图最重要的是确保发送给搜索引擎的消息与您的robots.txt文件一致。不要将已经通过robots.txt阻止的文件内容发送给搜素引擎; 考虑到网站的抓取预算,所以,我们千万别在这里犯错误。第二重要的是确保XML站点地图仅包含规范URL,因为Baidu/Google会将XML站点地图视为规范化信号。

URL规范化

如果站点上有重复的内容(我们应该避免出现重复的内容),那么rel =”canonical”链接元素告诉蜘蛛哪个URL应该被认为是主版本。如果不使用canonical标记,那么会导致网站上面不同URL但内容相同的页面被搜索引擎收录,会让搜索引擎误认为网站上面有很多重复页面,从而降低对网站的评价。

分页

正确设置rel =”next”和rel =”prev”链接元素非常重要。如果一个电子商务网站每个类别都有很多产品,如果想避免陷入搜索引擎的重复内容过滤器,那么rel = next和rel = prev就非常重要。

假设网站有50种不同的型号可供选择。在主类别页面上,用户可以查看前10个产品,每个产品都有一个产品名称和一个缩略图。然后,他们可以点击“下一页”来查看下一个10个结果,依此类推。

这些页面中的每一个都会具有相同或非常相似的标题,元描述和页面内容,因此主类别页面的头部应该有一个rel =“next”(no rel =“prev”,因为它是第一页)超文本标记语言(HTML)。将rel =“next”和rel =“prev”链接元素添加到每个后续页面会告诉抓取工具您要将这些页面用作序列。或者,如果我们该内容有“查看全部”页面,则可以在所有分页页面上规范化为“查看全部”页面,并完全跳过rel = prev / next。不足之处在于,“查看全部”页面可能会在搜索结果中显示。如果网页加载时间过长,搜索访问者的跳出率会很高,这不是一件好事。

如果没有rel =“canonical”,rel =“next”和rel =“prev”链接元素,这些页面将相互竞争排名,并且有重复的内容过滤的风险。正确实施,rel = prev / next将指示Google将序列视为一页,或者rel = canonical将所有权重配给“查看全部”页面。(关于分页优化技巧,各位同学可以查看这篇文章:页面分页优化技巧)

常见的编码问题

一个网站想要有很好的排名,是由很多因素共同决定的,其中,有一条很重要,那么就是:一个页面拥有简洁的代码很重要(Google的移动优先索引)。这样会让搜索引擎更容易辨别页面重要的内容。很有可能会因一个小错误导致蜘蛛使抓取者感到困惑,并导致搜索结果出现严重问题。

这里有几个基本的要注意的:

无限空间(又名蜘蛛陷阱)。糟糕的编码有时会无意中造成“无限空间”或“蜘蛛陷阱”。像指向相同内容的无尽URL或以多种方式呈现相同信息的页面等问题或包含不同日期无限日历的日历可能会导致蜘蛛卡住循环,从而可能很快耗尽您的爬取预算。在404错误页面的超文本传输协议安全(HTTP)标头中错误地提供200状态码是另一种呈现方式,所以,正确的页面状态码也是非常重要,也可以节约爬取预算。当一个蜘蛛遇到大量精简或重复的内容时,它最终会放弃,这可能意味着它永远无法获得最佳内容,并且会在索引中产生一堆无用的页面。

嵌入式内容。如果希望蜘蛛有效抓取网站的内容,最好让事情变得简单。搜索引擎蜘蛛经常遇到JavaScript,框架,Flash和异步JavaScript和XML(AJAX)的问题。尽管Baidu/Google在抓取Javascript和AJAX等格式方面做得越来越好,但使用HTML是最安全的。一个常见的例子是使用无限滚动的网站。虽然它可能会提高可用性,但它可能会让搜索引擎难以正确抓取您的内容并将其编入索引。确保每篇文章或产品页面都有唯一的URL,并且通过传统的链接结构连接,即使它以滚动格式显示。

欢迎 你 发表评论:

- 最新留言

-

- 我的生活

- 最美视野观赏

- 南柯电影网免费在线观看超前点播真的很棒??

- 最美视野观赏

- 最美视野

- 3117站长服务平台,专注于站长变现、交易支持。友链交换、购买、网站转让、买卖链接、软文发布等业务全覆盖。为站长提供互利共赢的合作环境,满足发稿、广告位买卖、泛目录租用等需求。助力推广和运营,让您的网站更成功!

- 我爱影视网 申请收录:https://www.5aiys.net

- 站长您好,申请收录网站名称:小静儿影视网站地址:https://xiaojinger.cc网站logo:https://xiaojinger.cc/upload/site/20230905-1/8759dc39df1a7329a406c875cb34005b.png网站介绍:小静儿影视是一个汇集全网的影视资源,永久免费在线观看。小静儿影视的免费资源类型广泛,涵盖电影、电视剧、综艺、动漫等,资源24小时及时更新。标签:小静儿影视,免费在线,全网影视,在线电影,在线视频

- 站长你好,我这边有意向在贵网站投放广告,望能够跟您合作,价格方面可以详谈您可以加我qq或者留下您的联系方式 qq:3599467958 telegram:@dashan9188 邮箱:uncauke@gmail.com 谢谢

- 站长您好,我们看到您的网页有提供关于免费影视网站资料的帮助,希望您能让我们的网站加入您的免费线上看影音网站列表。名称:飞流视频网址:https://www.flixflop.com简介:飞流视频是一个在线视频媒体影视平台,致力于提供丰富且最新线上看的内容,如电影、电视剧、动漫、综艺、纪录片等,主要满足用户免费在线观看视频的需求。希望早日收到您的好消息,谢谢站长~